Media Server

Soluciones de consulta, reproducción, almacenamiento e ingesta de archivos de videoLos sistemas digitales empiezan a implantarse progresivamente en la televisión desde finales de los años noventa; son sistemas complejos, que requieren una tecnología sofisticada y costosa, y cambian la forma de trabajo de muchos colectivos. En las cadenas generalistas el proceso comienza por el área de informativos diarios, programas estrella a los que dedican una gran cantidad de recursos económicos y humanos. Por supuesto, las cadenas que surgen en el nuevo milenio son digitales.

Los programas informativos diarios generan diferentes materiales, clasificados comúnmente en cuatro grandes apartados:

- Copia del programa completo, tal y como se ha emitido (copia paralelos de antena).

- Noticias, que los periodistas han editado para producir el informativo.

- Originales (brutos o rushes), grabados por los cámaras y que los redactores utilizan fragmentariamente para editar las noticias.

- Materiales de agencia (Reuters, APTN), de intercambio con otras televisiones, señales institucionales, etc., cuyos fragmentos emplean los redactores para la edición de las noticias.

El fruto de la televisión es la emisión; por eso, para organismos internacionales como la Fédération Internationale des Archives de Télevision (FIAT), la emisión es el material que ha de ser preservado por excelencia. En todos los casos, el material producido por la propia empresa es el material de preservación prioritaria, frente al material adquirido a terceros, y del cual no detenta los derechos de explotación. Recopilar el material emitido previamente grabado, o grabado en directo, nunca ha presentado dificultades para los servicios de documentación; pero además, en los sistemas digitales esta recuperación está automatizada, los ficheros digitales incluyen metadatos de producción y emisión y pueden acompañarse de otros elementos de interés, como las escaletas de los programas (Martínez; Mas, 2010; Andérez, 2009).

Sin embargo, no todos los archivos conservan el material emitido en los programas informativos, y algunas cadenas de televisión basan su política de explotación documental en los originales de cámara y señales recibidas. En los sistemas analógicos la recuperación de originales por parte del servicio de documentación ha sido siempre compleja: las cintas se entregaban sin información, a menudo semanas o meses después de su grabación, o no se entregaban (Giménez, 2007). En los sistemas digitales esto cambia de forma radical, ya que los originales de cámara, así como todo tipo de señales recibidas (noticias de agencia, intercambio, etc.), están disponibles para todos los colectivos interesados desde el momento de su ingesta, y los documentalistas pueden seleccionar, limpiar y guardar estas grabaciones para su catalogación y análisis.

Pero la digitalización también ha traído premura a las labores de selección, y no soluciona completamente la falta de información sobre los originales de cámara, especialmente cuando la tarea de ingesta corresponde al Servicio de Documentación (Aguilar Gutiérrez; López de Solís, 2010). Además, un archivo basado en originales sigue requiriendo tareas de selección complejas y costosas en recursos humanos (Giménez, 2007; Hidalgo, 2003; Grupo de selección, 2004).

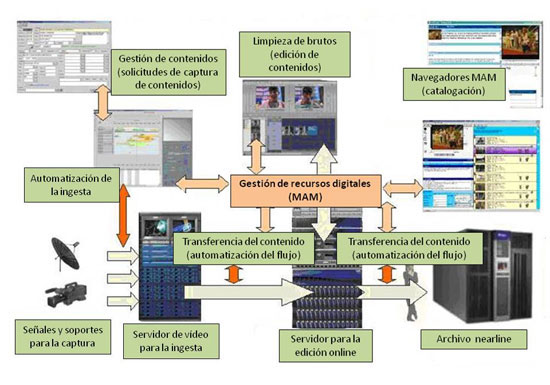

Con la digitalización de los centros de producción de televisión, las señales procedentes de las tarjetas de memoria de las ENGs, de los enlaces vía satélite o fibra óptica son codificadas en el videoservidor de ingesta, y convertidas en ficheros informáticos. Estos ficheros serán transferidos a un servidor online para que los periodistas (y también los documentalistas) accedan a ese contenido, puedan editarlo y generar una noticia.

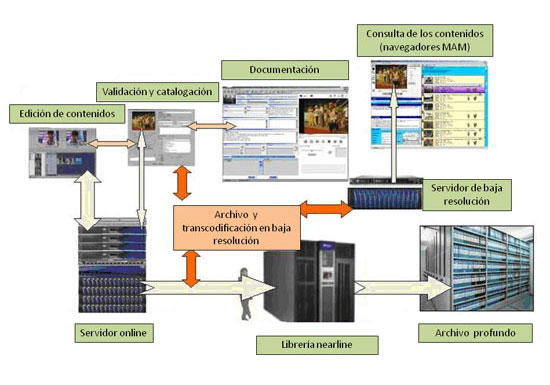

Los periodistas buscan los contenidos que necesitan para realizar su trabajo en el navegador; si ese contenido está en el archivoonline, un servidor de baja resolución le facilitará la imagen; en cambio, si el contenido está en la librería nearline, se producirá una transferencia automática desde la librería (o archivo nearline) a este servidor. Cuando el periodista termina su trabajo comienza el proceso de publicación del contenido con la generación del nuevo corte en el propio editor (fuse). Automáticamente, esa noticia va a ir a un videoservidor de play out o emisión, relacionado con la producción del estudio y la escaleta del programa, para su presentación en directo desde el plató, con las distintas noticias que se han producido durante el proceso de edición anterior.

Simultáneamente a la publicación del contenido se desencadenan procesos automáticos para que esa nueva noticia se archive en la librería nearline, y se desencadenan procesos de transcodificación que generan la nueva baja resolución de ese contenido. A partir de ahí, toda la organización puede visualizar ese contenido. Al final del proceso, cuando se haya archivado el contenido, les habrá llegado la fecha de caducidad a las copias disponibles en servidores de disco duro, una copia de alta resolución permanecerá en la librería y una versión de baja resolución en el servidor de baja resolución.

El sistema de gestión de contenidos audiovisuales (Media Asset Management) facilita los procesos automáticos para la gestión del almacenamiento digital, consiguiendo que durante todo el proceso de producción se vaya registrando exactamente dónde está el contenido, sin que nadie tenga que preocuparse por ello. Como señala Koldo Lizarralde (2009), subdirector de Ingeniería de ETB, las limpiezas automáticas de los servidores se gestionan adecuadamente gracias a que las catalogaciones previas son correctas, porque los contenidos deben mantenerse distinto tiempo en cada servidor dependiendo de su formato. Si se cataloga correctamente por formatos, distinguiendo claramente que esto es una noticia, un corte de edición, un programa de televisión, etc., todos estos procesos automáticos se desencadenarán de una forma eficiente. Este autor añade que una de las grandes dificultades que están conociendo, durante el proceso de años que es la digitalización de una emisora como ETB, es que la información en origen tiene que ser lo más fidedigna posible y no ha de haber errores en la clasificación de los contenidos para que los procesos automáticos se completen de una forma fiable.

CD MX (55) 4125 0121 - Email:

CD MX (55) 4125 0121 - Email: